ollama

$ docker exec -it ollama sh

# ollama list

NAME ID SIZE MODIFIED

llama4:latest b62dea0de67c 67 GB 3 weeks ago

mistral-small3.1:latest b9aaf0c2586a 15 GB 6 weeks ago

llama3.2-vision:90b d2a5e64c56a9 54 GB 7 weeks ago

llava:34b 3d2d24f46674 20 GB 7 weeks ago

gemma3:27b a418f5838eaf 17 GB 7 weeks ago

bge-m3:latest 790764642607 1.2 GB 8 weeks ago

exaone-deep:2.4b 37d6b495c16c 1.6 GB 2 months ago

deepseek-r1:7b 0a8c26691023 4.7 GB 2 months ago

exaone3.5:latest c7c4e3d1ca22 4.8 GB 2 months ago

qwq:32b cc1091b0e276 19 GB 2 months ago

all-minilm:l6-v2 1b226e2802db 45 MB 3 months ago

nomic-embed-text:latest 0a109f422b47 274 MB 3 months ago

deepseek-r1:671b 739e1b229ad7 404 GB 3 months ago

smollm2:135m 9077fe9d2ae1 270 MB 4 months ago

deepseek-r1:70b 0c1615a8ca32 42 GB 4 months ago

deepseek-r1:32b 38056bbcbb2d 19 GB 4 months ago

llama3.3:latest a6eb4748fd29 42 GB 5 months ago

qwen2.5-coder:32b 4bd6cbf2d094 19 GB 5 months ago

deepseek-coder-v2:latest 63fb193b3a9b 8.9 GB 5 months ago

starcoder2:15b 21ae152d49e0 9.1 GB 6 months ago

llama3.2:latest a80c4f17acd5 2.0 GB 8 months ago

mistral-nemo:latest 994f3b8b7801 7.1 GB 8 months ago

qwen2.5-coder:7b 87098ba7390d 4.7 GB 8 months ago

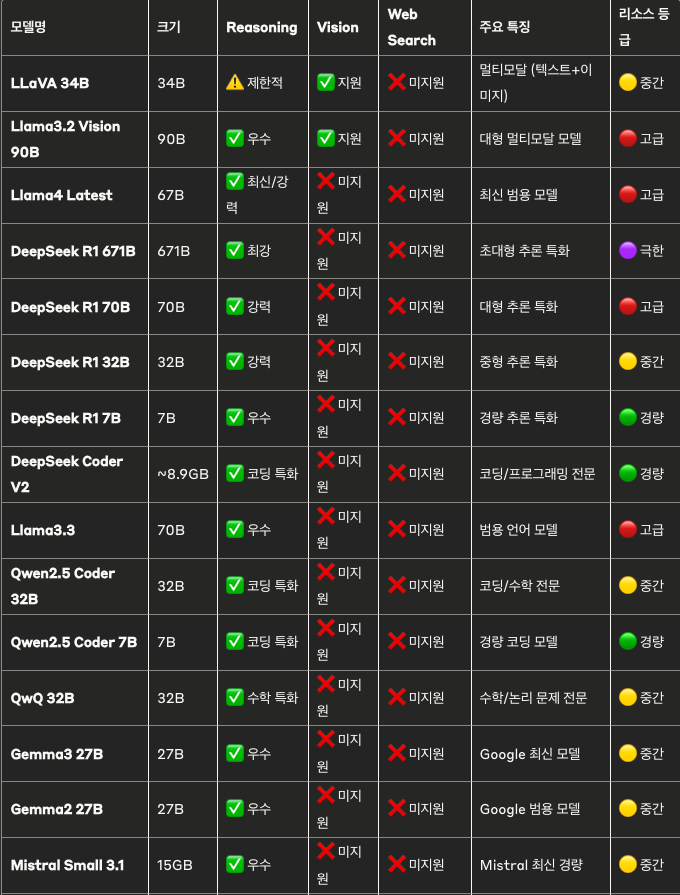

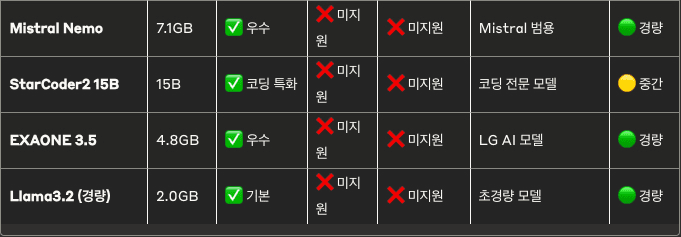

gemma2:27b 53261bc9c192 15 GB 8 months agoAI 모델별 기능 지원 현황표

전체 모델 현황 (19개 모델)

범례

기능 지원 수준

- ✅ 지원: 해당 기능을 완전히 지원

- ⚠️ 제한적: 기본적인 수준의 지원

- ❌ 미지원: 해당 기능을 지원하지 않음

리소스 등급

- 🟣 극한 (400GB+ RAM): 특수 하드웨어 필요

- 🔴 고급 (40GB+ RAM): 고성능 GPU/대용량 메모리 필요

- 🟡 중간 (15-40GB RAM): 중급 하드웨어

- 🟢 경량 (2-10GB RAM): 일반 하드웨어에서 실행 가능

카테고리별 분류

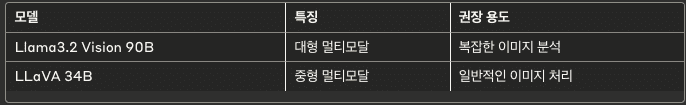

🎯 Vision 지원 모델 (2개)

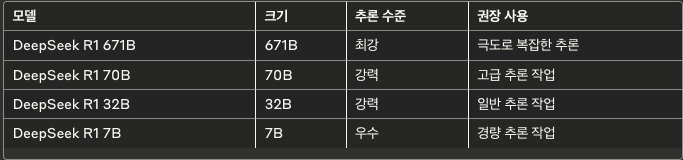

🧠 추론 특화 모델 (4개)

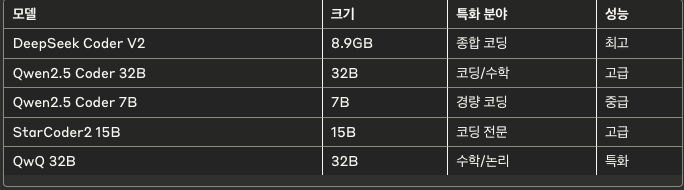

💻 코딩 특화 모델 (5개)

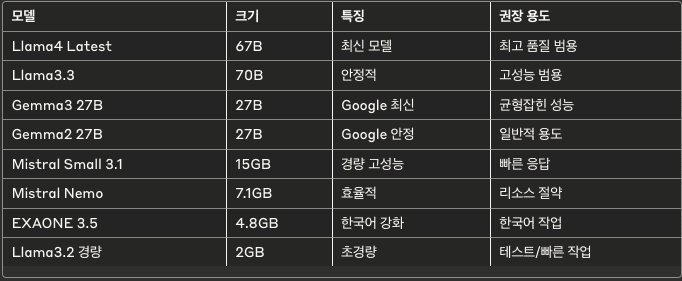

🌐 범용 모델 (8개)

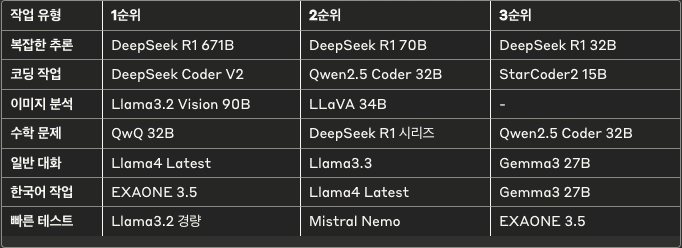

💡 권장 사용 시나리오

🎯 작업별 최적 모델

⚠️ 리소스 고려사항

- 메모리 부족 시: 🟢 경량 모델 우선 사용

- 고성능 필요 시: 🔴 고급 모델 선택적 사용

- 안정성 우선 시: 검증된 Llama/Gemma 시리즈 활용